La inteligencia artificial ha permitido algunos de los mayores avances en fotografía en los últimos años, y no hay razón para pensar que el progreso se ralentizará. Si te estás preguntando qué tan buena será la cámara del próximo teléfono, sería una buena idea prestar atención a lo que el fabricante tenga que decir sobre la inteligencia artificial.

La inteligencia artificial está ayudando a las cámaras a volverse más inteligentes y más eficientes para comprender el mundo que les rodea. Esto se traduce en algunos avances impresionantes en fotografía, especialmente cuando se trata de tecnologías de software. Al darle a las cámaras un mejor entendimiento de su entorno, la inteligencia artificial ayuda a mejorar la calidad general de las fotos y hace que el proceso de tomarlas y editarlas sea mucho más fácil.

Con el lanzamiento de Google Photos en 2015, el gigante de los buscadores, hizo una clara demostración del poder de mezclar inteligencia artificial y fotografía. Hasta entonces, Google había estado utilizando el aprendizaje automático para categorizar imágenes en Google+ durante años, pero el lanzamiento de su aplicación Photos incluyó características de inteligencia artificial orientadas al consumidor que a la mayoría les habrían resultado inconcebibles. De repente, o eso parecía, Google sabía cómo se veía tu gato. Hacía tiempo que no veías una foto de tu gato, pero ahí estaba él, en toda su gloria felina, en la página principal de tu dispositivo Google.

Google lleva trabajando en el desarrollo de una inteligencia artificial capaz de reconocer objetos así como humanos, (ya vimos el caso del porqué se están volviendo tan complicados los CAPTCHAS y su posible lado oculto). Todo comenzó en 2013, cuando adquirieron DNNresearch, que era una red neuronal profunda. Luego la configuraron y la entrenaron con datos que habían sido etiquetados por humanos. Este proceso se llama aprendizaje supervisado e involucra el entrenamiento de la red con millones de imágenes para que pueda buscar pistas visuales a nivel de píxeles para ayudar a identificar la categoría. Con el tiempo, el algoritmo va mejorando y consigue reconocer mejor las cosas. Por ejemplo, aprende dónde suele estar el pelo negro y el pelo blanco en relación uno con otro en un panda, y cómo se diferencia del pelaje de una vaca Holstein. Con más entrenamiento, es posible buscar términos más abstractos como «animal» o «desayuno», que pueden no tener indicadores visuales comunes pero son inmediatamente obvios para los humanos.

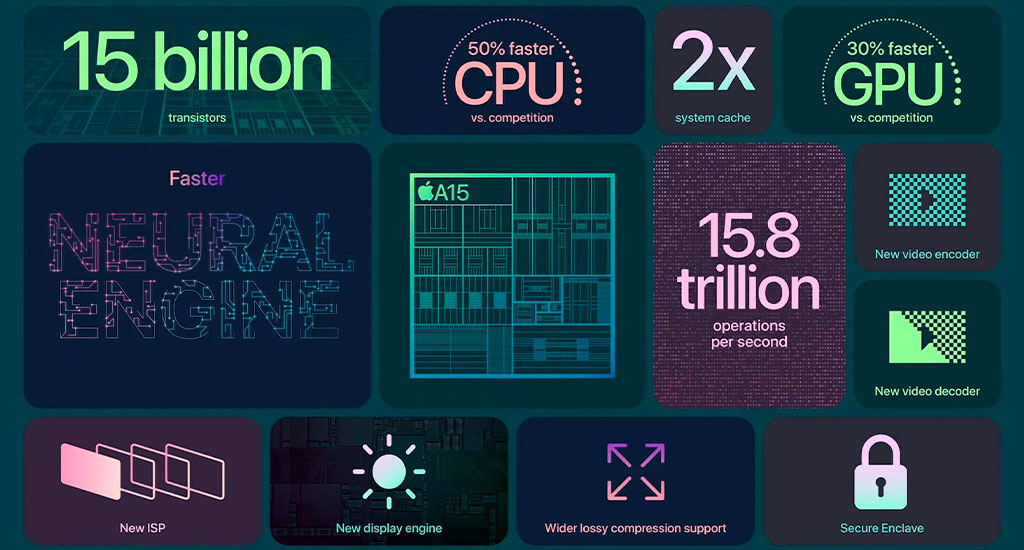

Los programas modernos de gestión de fotos hacen mucho más que solo almacenar y ordenar tus imágenes. Utilizan inteligencia artificial y aprendizaje automático para mejorarlas automáticamente, obteniendo mejores resultados con poca o ninguna entrada por parte del usuario. Esto es posible gracias a que cada vez tenemos más potencia en los procesadores de los teléfonos. Al combinar un CPU, un procesador de señales de imagen y un NPU, estos chips son capaces de mejorar significativamente la calidad de las imágenes capturadas por teléfonos y otros dispositivos.

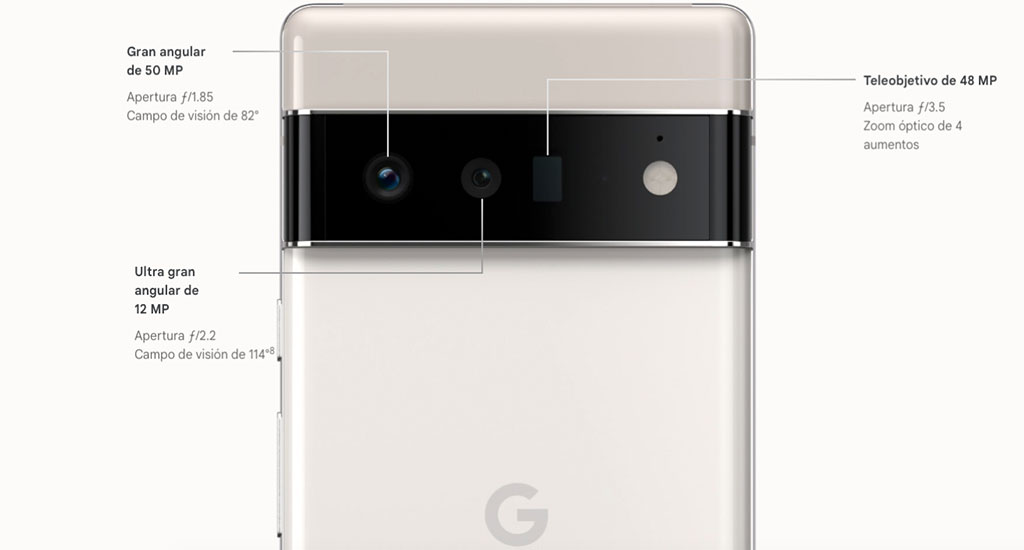

Este es el hardware que se utiliza en la fotografía computacional, un término que abarca desde los efectos falsos de profundidad de campo en los modos retrato de los teléfonos hasta los algoritmos que ayudan a impulsar la increíble calidad de imagen del Google Pixel. La inteligencia artificial es un componente importante de la fotografía computacional, pero no es lo único involucrado.

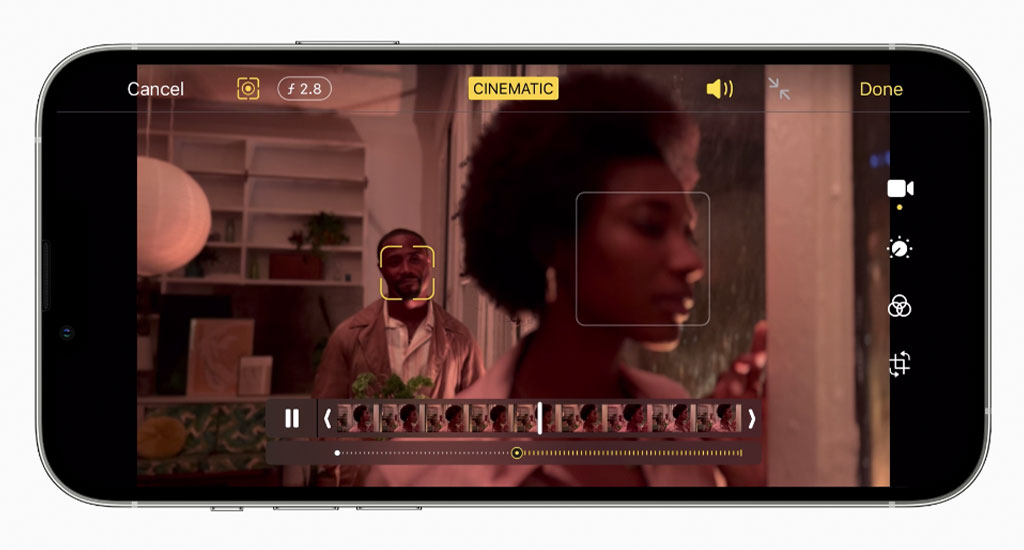

El uso por parte de Apple de aprendizaje automático para el modo retrato con cámara dual del iPhone (o cámara triple de los Pro) es un avance significativo. Esta tecnología permite al procesador de señales de imagen del iPhone reconocer personas con una cámara, mientras que la segunda cámara (o escáner LiDar en los modelos Pro) crea un mapa de profundidad para ayudar a aislar el tema y difuminar el fondo. La capacidad para reconocer personas a través del aprendizaje automático en tiempo real es lo que hace que esta función se destaque entre otros programas de gestión de fotos.

Uno de los líderes en el campo de la fotografía de teléfonos inteligentes es Google, con los excelentes resultados de las tres generaciones de Pixel como la mejor prueba. El modo de disparo HDR+, que es el modo predeterminado, usa un algoritmo complicado que combina varios fotogramas subexpuestos en uno, y, según Marc Levoy, líder de fotografía computacional de Google, el aprendizaje automático significa que el sistema solo mejora con el tiempo. Google ha entrenado a su IA en un gran conjunto de datos de imágenes etiquetadas, similar al software Google Photos, que ayuda a la cámara con la exposición.

En un restaurante o bar oscuros, por ejemplo, las fotos tomadas con Night Sight parecen brillantes y claras, con colores precisos y muy poco ruido, l igual que la imagen de la misma escena tomada con el modo Night Mode del iPhone 13 Pro Max.

Los Honor View 20 y Huawei Nova 4 son los primeros teléfonos en usar el sensor de imagen Sony IMX586. Este sensor es más grande que la mayoría de los competidores y, con 48 megapíxeles, representa la mayor resolución hasta ahora vista en un teléfono. Sin embargo, esto todavía significa empacar una gran cantidad de pequeños píxeles en un espacio pequeño, lo que suele ser un problema para la calidad de la imagen. En mis pruebas View 20, el modo “AI Ultra Clarity” de Honor brilla en sacar el máximo provecho de la resolución,

A medida que avanza la fotografía computacional, los procesadores de señales de imagen y los NPUs están desempeñando un papel cada vez más importante en el rendimiento de la cámara del teléfono. Huawei fue la primera empresa en anunciar un sistema-en-chip con hardware dedicado para IA, el Kirin 970, aunque el A11 Bionic de Apple llegó a los consumidores primero. Qualcomm, el mayor proveedor de procesadores Android en todo el mundo, todavía no ha hecho del aprendizaje automático un foco principal, pero Google ha desarrollado su propio chip llamado Pixel Visual Core para ayudar con la IA

Este tipo de hardware será cada vez más importante para realizar cálculos de aprendizaje automático eficientes y eficaces en el dispositivo. Recuerda, el tipo de algoritmos que impulsan Google Photos fueron entrenados en enormes computadoras potentes con GPUs potentes y núcleos tensor antes de ser liberados en su biblioteca de fotos. Mucho del trabajo se puede hacer “de antemano”, por así decirlo, pero la capacidad de llevar a cabo cálculos de aprendizaje automático en un dispositivo móvil en tiempo real sigue siendo de vanguardia.

La cámara es una de las características más importantes de cualquier teléfono, y AI es nuestra mejor oportunidad para mejorarla. Google ha mostrado un excelente trabajo que podría reducir la carga de procesamiento, mientras que los motores neuronales son cada vez más rápidos año tras año. Pero incluso en esta etapa temprana de la fotografía computacional, existen beneficios reales que se pueden encontrar en las cámaras de teléfono que han sido diseñadas en torno al aprendizaje automático. De hecho, de todas las posibilidades y aplicaciones levantadas por la ola del hype IA de los últimos años, el área donde estamos viendo los resultados más tangibles se encuentra justo aquí en nuestros bolsillos.